Voici les sorties :

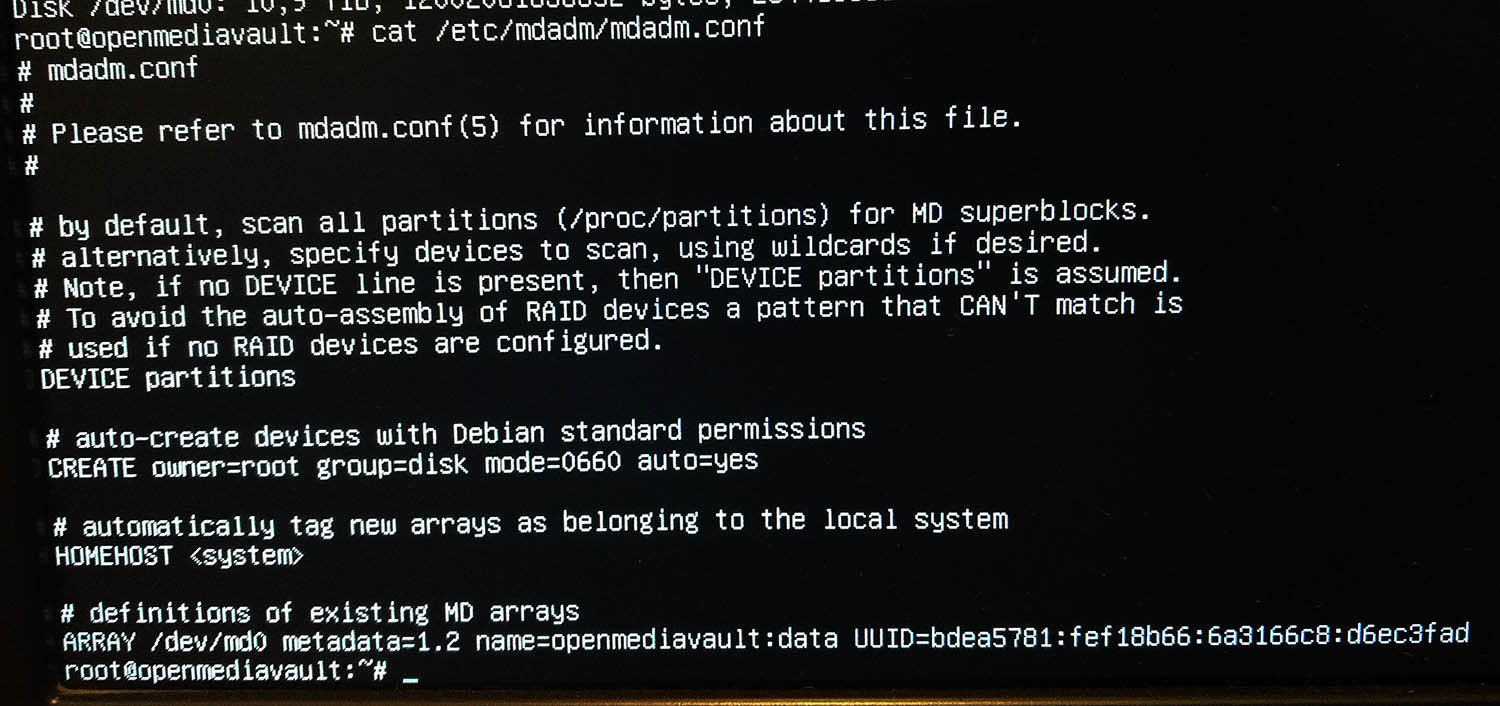

/etc/mdadm/mdadm.conf

[code] # mdadm.conf

Please refer to mdadm.conf(5) for information about this file.

by default, scan all partitions (/proc/partitions) for MD superblocks.

alternatively, specify devices to scan, using wildcards if desired.

Note, if no DEVICE line is present, then “DEVICE partitions” is assumed.

To avoid the auto-assembly of RAID devices a pattern that CAN’T match is

used if no RAID devices are configured.

DEVICE partitions

auto-create devices with Debian standard permissions

CREATE owner=root group=disk mode=0660 auto=yes

automatically tag new arrays as belonging to the local system

HOMEHOST

definitions of existing MD arrays

ARRAY /dev/md0 metadata=1.2 name=openmediavault:data UUID=bdea5781:fef18b66:6a3166c8:d6ec3fad[/code]

/etc/fstab

[code] # /etc/fstab: static file system information.

Use ‘blkid’ to print the universally unique identifier for a

device; this may be used with UUID= as a more robust way to name devices

that works even if disks are added and removed. See fstab(5).

/ was on /dev/sda1 during installation

UUID=a46dc94f-d2a0-44a9-be3d-6534fdd4ef7b / ext4 errors=remount-ro 0 1

swap was on /dev/sda5 during installation

UUID=d43c8706-d52c-4597-b93a-613fc622d145 none swap sw 0 0

tmpfs /tmp tmpfs defaults 0 0

>>> [openmediavault]

/dev/disk/by-id/md-name-openmediavault:data /srv/dev-disk-by-id-md-name-openmediavault-data ext4 defaults,nofail,user_xattr,noexec,usrjquota=aquota.user,grpjquota=aquota.group,jqfmt=vfsv0,acl 0 2

<<< [openmediavault][/code]

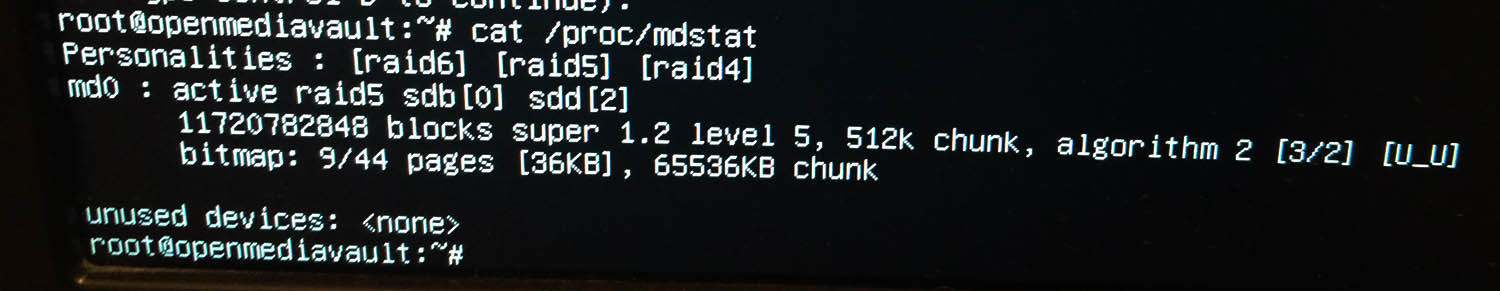

/proc/mdstat

[code] Personalities : [raid6] [raid5] [raid4]

md0 : active raid5 sdb[0] sdd[2]

11720782848 blocks super 1.2 level 5, 512k chunk, algorithm 2 [3/2] [U_U]

bitmap: 10/44 pages [40KB], 65536KB chunk

unused devices: [/code]

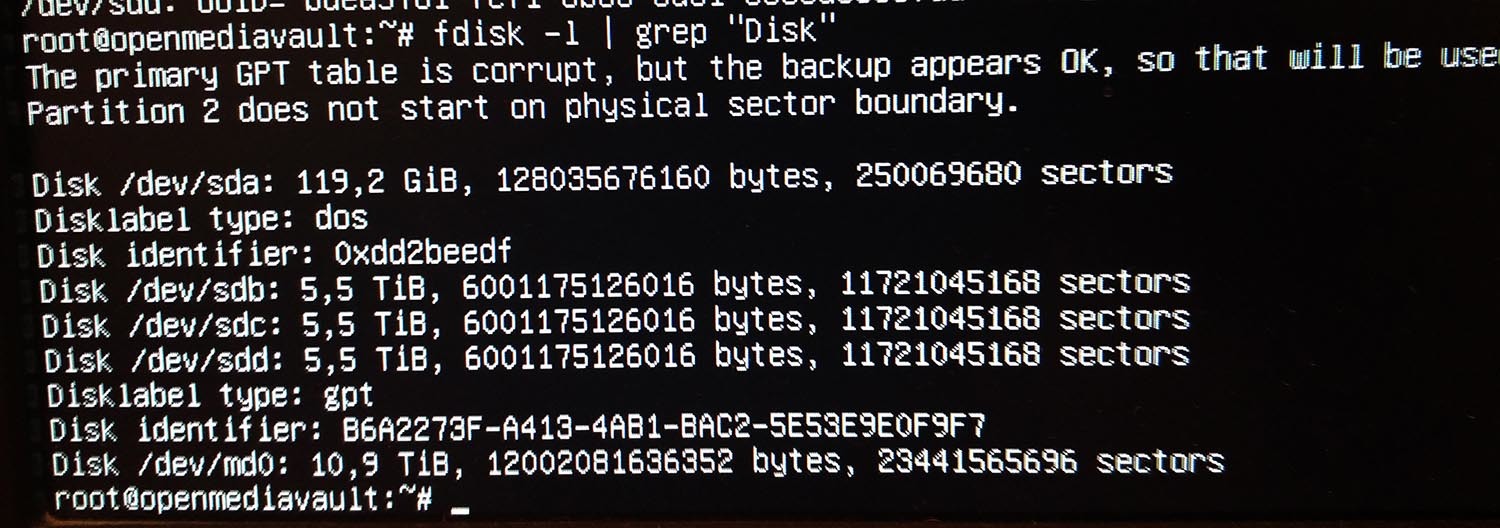

fdisk -l

[code] Disk /dev/sdb: 5,5 TiB, 6001175126016 bytes, 11721045168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/sda: 119,2 GiB, 128035676160 bytes, 250069680 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: dos

Disk identifier: 0xdd2beedf

Device Boot Start End Sectors Size Id Type

/dev/sda1 * 2048 239855615 239853568 114,4G 83 Linux

/dev/sda2 239857662 250068991 10211330 4,9G 5 Extended

/dev/sda5 239857664 250068991 10211328 4,9G 82 Linux swap / Solaris

Disk /dev/sdd: 5,5 TiB, 6001175126016 bytes, 11721045168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disklabel type: gpt

Disk identifier: B6A2273F-A413-4AB1-BAC2-5E53E9E0F9F7

Device Start End Sectors Size Type

/dev/sdd1 34 262177 262144 128M Microsoft reserved

Disk /dev/sdc: 5,5 TiB, 6001175126016 bytes, 11721045168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/md0: 10,9 TiB, 12002081636352 bytes, 23441565696 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 524288 bytes / 1048576 bytes

Disk /dev/sdf: 962 MiB, 1008730112 bytes, 1970176 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: dos

Disk identifier: 0x00124fa5

Device Boot Start End Sectors Size Id Type

/dev/sdf1 * 2048 1970175 1968128 961M b W95 FAT32

[/code]

mdadm --examine --scan

blkid

/dev/sdb: UUID="bdea5781-fef1-8b66-6a31-66c8d6ec3fad" UUID_SUB="5228664a-20d1-3bbd-f6e0-53f30d82d0bf" LABEL="openmediavault:data" TYPE="linux_raid_member"

/dev/sda1: UUID="a46dc94f-d2a0-44a9-be3d-6534fdd4ef7b" TYPE="ext4" PARTUUID="dd2beedf-01"

/dev/sda5: UUID="d43c8706-d52c-4597-b93a-613fc622d145" TYPE="swap" PARTUUID="dd2beedf-05"

/dev/sdd: UUID="bdea5781-fef1-8b66-6a31-66c8d6ec3fad" UUID_SUB="45f17caa-caf2-18c8-b73a-05fc62ba5390" LABEL="openmediavault:data" TYPE="linux_raid_member"

/dev/md0: LABEL="data" UUID="40aaf943-537c-4184-9d36-f37ee244b0ff" TYPE="ext4"

/dev/sdc: UUID="bdea5781-fef1-8b66-6a31-66c8d6ec3fad" UUID_SUB="e5f75494-2b65-e546-783f-dd4dc4614d29" LABEL="openmediavault:data" TYPE="linux_raid_member"

/dev/sdf1: LABEL="USB" UUID="1CCE-38C4" TYPE="vfat" PARTUUID="00124fa5-01"

)

)