blkid

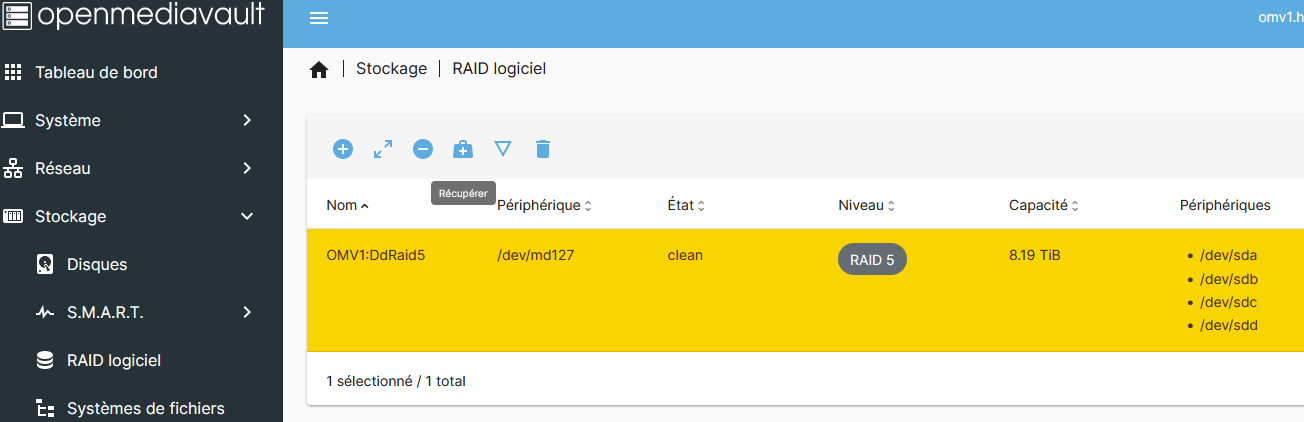

/dev/sdd: UUID="f125d73b-17d5-0597-dd60-db60ff557073" UUID_SUB="f4d8aaae-4f6d-40f6-a9f3-38a1aedfa0c8" LABEL="OMV1:DdRaid5" TYPE="linux_raid_member"

/dev/sde1: UUID="08c3871d-7232-4b4f-9acc-8f521db0dc1a" BLOCK_SIZE="4096" TYPE="ext4" PARTUUID="ab072bde-01"

/dev/sde5: UUID="4ea674ac-b4cb-40ef-9922-56260fa48d88" TYPE="swap" PARTUUID="ab072bde-05"

/dev/sdb: UUID="f125d73b-17d5-0597-dd60-db60ff557073" UUID_SUB="a65a3112-c7db-a0e4-03e7-8f4f19d265e4" LABEL="OMV1:DdRaid5" TYPE="linux_raid_member"

/dev/sda: UUID="f125d73b-17d5-0597-dd60-db60ff557073" UUID_SUB="163f9575-1204-c670-407f-a9648abb5acc" LABEL="OMV1:DdRaid5" TYPE="linux_raid_member"

/dev/sdc: UUID="f125d73b-17d5-0597-dd60-db60ff557073" UUID_SUB="7a286c96-71b2-5fca-06b5-578b07e937d7" LABEL="OMV1:DdRaid5" TYPE="linux_raid_member"

/dev/md127: LABEL="Fil1" UUID="dad71d93-597e-435e-b28f-10ac4bd46498" BLOCK_SIZE="4096" TYPE="ext4"

findmnt

TARGET SOURCE FSTYPE OPTIONS

/ /dev/sde1 ext4 rw,relatime,errors=remount-ro

├─/sys sysfs sysfs rw,nosuid,nodev,noexec,relatime

│ ├─/sys/kernel/security securityfs securityfs rw,nosuid,nodev,noexec,relatime

│ ├─/sys/fs/cgroup cgroup2 cgroup2 rw,nosuid,nodev,noexec,relatime,nsdelegate,memory_recursiveprot

│ ├─/sys/fs/pstore pstore pstore rw,nosuid,nodev,noexec,relatime

│ ├─/sys/fs/bpf bpf bpf rw,nosuid,nodev,noexec,relatime,mode=700

│ ├─/sys/kernel/debug debugfs debugfs rw,nosuid,nodev,noexec,relatime

│ ├─/sys/kernel/tracing tracefs tracefs rw,nosuid,nodev,noexec,relatime

│ ├─/sys/kernel/config configfs configfs rw,nosuid,nodev,noexec,relatime

│ └─/sys/fs/fuse/connections fusectl fusectl rw,nosuid,nodev,noexec,relatime

├─/proc proc proc rw,nosuid,nodev,noexec,relatime

│ └─/proc/sys/fs/binfmt_misc systemd-1 autofs rw,relatime,fd=30,pgrp=1,timeout=0,minproto=5,maxproto=5,direct,pipe_

├─/dev udev devtmpfs rw,nosuid,relatime,size=1879204k,nr_inodes=469801,mode=755,inode64

│ ├─/dev/pts devpts devpts rw,nosuid,noexec,relatime,gid=5,mode=620,ptmxmode=000

│ ├─/dev/shm tmpfs tmpfs rw,nosuid,nodev,inode64

│ ├─/dev/mqueue mqueue mqueue rw,nosuid,nodev,noexec,relatime

│ └─/dev/hugepages hugetlbfs hugetlbfs rw,relatime,pagesize=2M

├─/run tmpfs tmpfs rw,nosuid,nodev,noexec,relatime,size=389492k,mode=755,inode64

│ ├─/run/lock tmpfs tmpfs rw,nosuid,nodev,noexec,relatime,size=5120k,inode64

│ └─/run/rpc_pipefs sunrpc rpc_pipefs rw,relatime

└─/tmp tmpfs tmpfs rw,relatime,inode64