Bonjour,

c’est un peut la panique de mon coté, je prie pour que quelqu’un puisse m’aider…

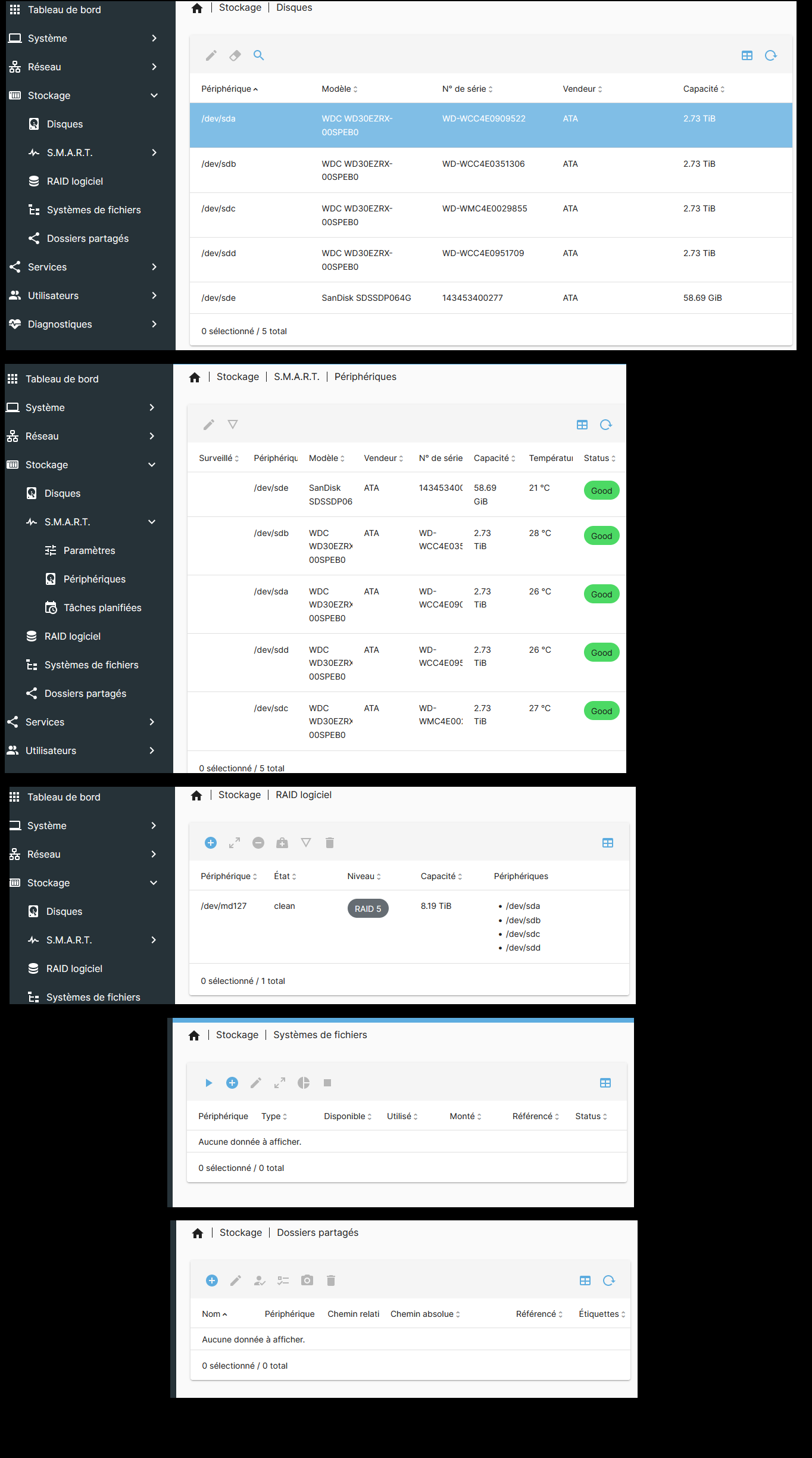

J’avais un serveur nas OMV v4, dans un HP Proliant micro Serveur N54L, connecté au réseau en rj45, qui contient 1 SSD de 64Gb avec l’OS dessus, et 4 disques dure de 3 Tb chacun, montés en raid 5.

dessus j’utilisais les services samba et miniDLNA…

Ca c’était il y a 4 jours…

Et la commence la spirale…

Impossible d’accéder à mes films en DLNA avec ni la box, ni la TV, ni le rPi en média player, ni chrome cast…

Les accès Samba via mon portable et un petit fixe se déconnectent au bout de 20sec à environ 10min, pareil pour l’interface d’admin…

j’interprète cela comme une fin annoncé… j’arrive quand même à voir le journal SMART des mes disques et, de souvenir, tout va bien… (je n’ai plus de souvenir précis des log

je me dit alors qu’il est peut être temps de migrer de version d’OMV je regarde… on en est à la version 6… je la télécharge…

Il y à quelque temps j’avais déjà réussit à faire la migration d’OMV v3 => v4 tout s’était bien passé et il avait automatiquement retrouver le raid 5, mes 4 répertoires racines, et toutes les données qu’il y à sur les disque…

j’installe donc OMV v6, je fait un « sudo apt update » suivi d’un « sudo apt upgrade », je rentre dans l’interface…

et là le drame… je ne vois plus mes répertoires racine… (comme s’était le cas dans l’installation d’omv v3 vers v’)

je vois bien les disques en raid 5 avec la notation « Clean » mais ou s’ont passé mes données?

et en plus il y à une notion de « montage de volume » que j’hésite à faire de peur de perdre mes données…

Savez vous ce que je peux faire?

Merci beaucoup, Beaucoup, BEAUCOUP!..