Bonjour à tous !

Petit soucis sur mon serveur de stockage Ubuntu

J’ai créer un md0 avec plusieurs disque dur mais j’ai fait un reboot du serveur et dû coup Le md0 a pas été monté

Comment je peux régler ce soucis ?

Merci

Bonjour à tous !

Petit soucis sur mon serveur de stockage Ubuntu

J’ai créer un md0 avec plusieurs disque dur mais j’ai fait un reboot du serveur et dû coup Le md0 a pas été monté

Comment je peux régler ce soucis ?

Merci

Bonjour,

ici c’est du Debian en fait  Ton /dev/md0 c’est un raid 5 un raid 1? autre chose?

Ton /dev/md0 c’est un raid 5 un raid 1? autre chose?

Ton md0 ce n’est pas une partition c’est juste un device, donc évidement tu ne peux pas le monter, il faut créer des partitions dessus pour cela.

ARRAY /dev/md/0 level=raid0 metadata=1.2 num-devices=11 UUID=1f6b5d41:eacdf783:726438b8:415a5815 name=srv60805:0

devices=/dev/sdk,/dev/sdj,/dev/sdl,/dev/sdh,/dev/sdi,/dev/sde,/dev/sdg,/dev/sdf,/dev/sdd,/dev/sdb,/dev/sdc

J’ai sa en tapant :

nano /etc/mdadm/mdadm.conf

Tout été nickel j’avais tout mes disques dur monté sur le mon dossier /raid

J’ai reboot et plus rien

mdadm --detail /dev/md0

/dev/md0:

Version : 1.2

Raid Level : raid0

Total Devices : 8

Persistence : Superblock is persistent

State : inactive

Working Devices : 8

Name : srv60805:0 (local to host srv60805)

UUID : 1f6b5d41:eacdf783:726438b8:415a5815

Events : 0

Number Major Minor RaidDevice

- 8 64 - /dev/sde

- 8 176 - /dev/sdl

- 8 144 - /dev/sdj

- 8 112 - /dev/sdh

- 8 80 - /dev/sdf

- 8 160 - /dev/sdk

- 8 128 - /dev/sdi

- 8 96 - /dev/sdg

Donne nous plutôt le contenu de ton fichier fstab et le retour de la commande mount ainsi que parted -l …

Tes disques sont tous de la même taille? Car ton RAID 0 va etre en fonction de la taille la plus petite (si tu as 3 disque 200G 300G et 400G, la taille de ton RAID0 sera de 600G, les 300G restant seront inutilisés.

Avec du LVM tu pourrais utiliser tout l’espace de tes disques.

mais effectivement il faudrait voir comment tu as partitionné ton RAID ensuite et voir ton fstab.

Tout les disques sont de la même taille

En faite tout fonctionner bien jusqu’à que je reboot le serveur

mount: /raid: wrong fs type, bad option, bad superblock on /dev/md0, missing codepage or helper program, or other error.

J’avais créer un dossier /raid pour mettre tout mes fichiers dedans, une fois reboot tout a disparu

Peux tu éviter les images et récupérer des copier coller des retours demandés ce sera plus lisible

Il nous manque encore le retour de la commande mount (juste mount ^^ rien à taper de plus) ainsi que le retour de parted -l …

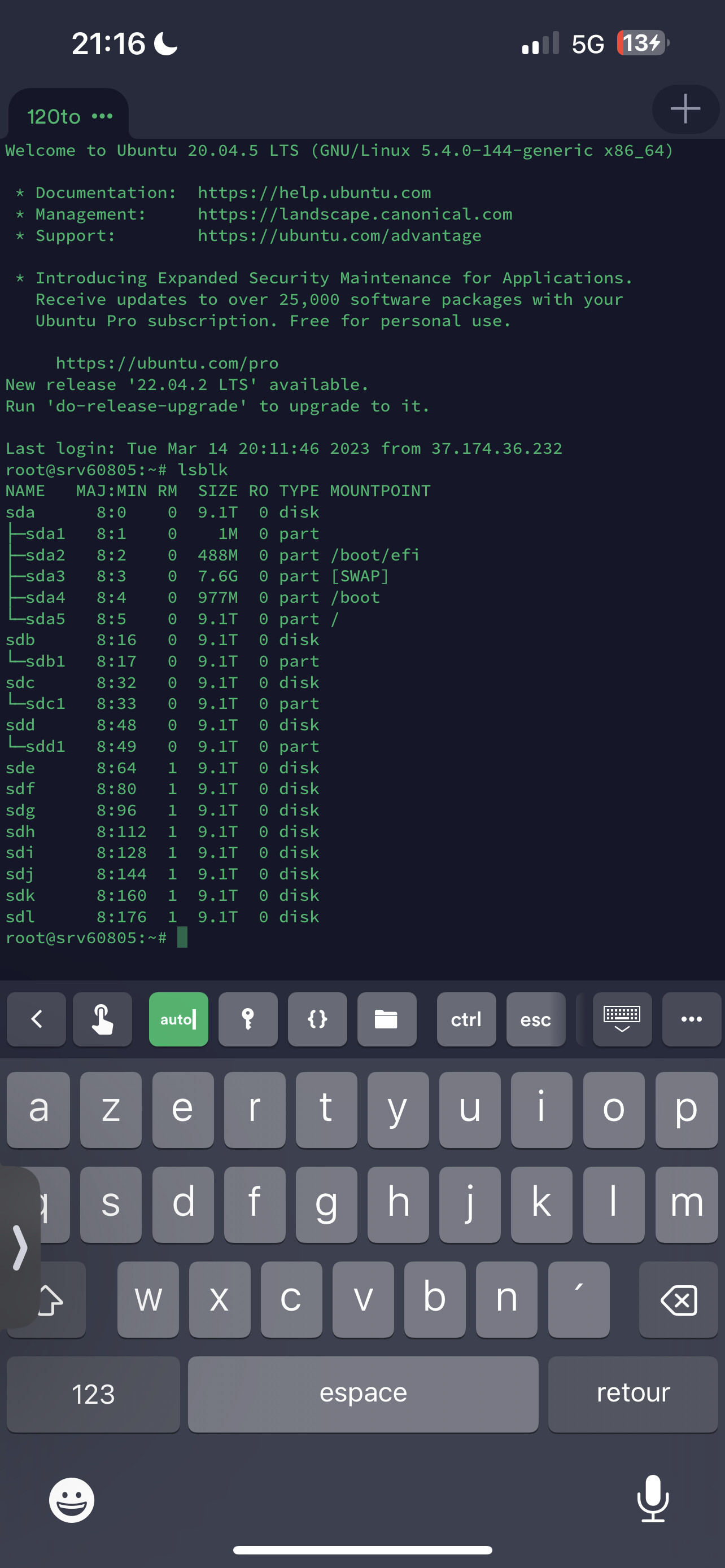

Autre chose lsblk n’indique aucune partition sur les disques de sde à sdl et une partition sur les disques de sdb à sdd, c’est compliqué de comprendre ce que tu as fait.

A priori si tu ne retrouve pas de donnée et que la commande mount indique bien un ensemble raid md0 sur le point de montage /raid c’est qu’il y a un souci avec la partition créer sur cet ensemble raid.

root@srv60805:~# mount

sysfs on /sys type sysfs (rw,nosuid,nodev,noexec,relatime)

proc on /proc type proc (rw,nosuid,nodev,noexec,relatime)

udev on /dev type devtmpfs (rw,nosuid,noexec,relatime,size=16331968k,nr_inodes=4082992,mode=755)

devpts on /dev/pts type devpts (rw,nosuid,noexec,relatime,gid=5,mode=620,ptmxmode=000)

tmpfs on /run type tmpfs (rw,nosuid,nodev,noexec,relatime,size=3272580k,mode=755)

/dev/sda5 on / type ext4 (rw,relatime,errors=remount-ro)

securityfs on /sys/kernel/security type securityfs (rw,nosuid,nodev,noexec,relatime)

tmpfs on /dev/shm type tmpfs (rw,nosuid,nodev)

tmpfs on /run/lock type tmpfs (rw,nosuid,nodev,noexec,relatime,size=5120k)

tmpfs on /sys/fs/cgroup type tmpfs (ro,nosuid,nodev,noexec,mode=755)

cgroup2 on /sys/fs/cgroup/unified type cgroup2 (rw,nosuid,nodev,noexec,relatime,nsdelegate)

cgroup on /sys/fs/cgroup/systemd type cgroup (rw,nosuid,nodev,noexec,relatime,xattr,name=systemd)

pstore on /sys/fs/pstore type pstore (rw,nosuid,nodev,noexec,relatime)

efivarfs on /sys/firmware/efi/efivars type efivarfs (rw,nosuid,nodev,noexec,relatime)

none on /sys/fs/bpf type bpf (rw,nosuid,nodev,noexec,relatime,mode=700)

cgroup on /sys/fs/cgroup/freezer type cgroup (rw,nosuid,nodev,noexec,relatime,freezer)

cgroup on /sys/fs/cgroup/net_cls,net_prio type cgroup (rw,nosuid,nodev,noexec,relatime,net_cls,net_prio)

cgroup on /sys/fs/cgroup/rdma type cgroup (rw,nosuid,nodev,noexec,relatime,rdma)

cgroup on /sys/fs/cgroup/blkio type cgroup (rw,nosuid,nodev,noexec,relatime,blkio)

cgroup on /sys/fs/cgroup/hugetlb type cgroup (rw,nosuid,nodev,noexec,relatime,hugetlb)

cgroup on /sys/fs/cgroup/pids type cgroup (rw,nosuid,nodev,noexec,relatime,pids)

cgroup on /sys/fs/cgroup/devices type cgroup (rw,nosuid,nodev,noexec,relatime,devices)

cgroup on /sys/fs/cgroup/cpuset type cgroup (rw,nosuid,nodev,noexec,relatime,cpuset)

cgroup on /sys/fs/cgroup/cpu,cpuacct type cgroup (rw,nosuid,nodev,noexec,relatime,cpu,cpuacct)

cgroup on /sys/fs/cgroup/memory type cgroup (rw,nosuid,nodev,noexec,relatime,memory)

cgroup on /sys/fs/cgroup/perf_event type cgroup (rw,nosuid,nodev,noexec,relatime,perf_event)

systemd-1 on /proc/sys/fs/binfmt_misc type autofs (rw,relatime,fd=29,pgrp=1,timeout=0,minproto=5,maxproto=5,direct,pipe_ino=17319)

mqueue on /dev/mqueue type mqueue (rw,nosuid,nodev,noexec,relatime)

debugfs on /sys/kernel/debug type debugfs (rw,nosuid,nodev,noexec,relatime)

tracefs on /sys/kernel/tracing type tracefs (rw,nosuid,nodev,noexec,relatime)

hugetlbfs on /dev/hugepages type hugetlbfs (rw,relatime,pagesize=2M)

fusectl on /sys/fs/fuse/connections type fusectl (rw,nosuid,nodev,noexec,relatime)

configfs on /sys/kernel/config type configfs (rw,nosuid,nodev,noexec,relatime)

tmpfs on /home/onestream/iptv/storage/app/streams type tmpfs (rw,relatime,size=22908052k)

tmpfs on /home/onestream/iptv/storage/framework/cache type tmpfs (rw,relatime,size=1636292k)

/dev/sda4 on /boot type ext4 (rw,relatime)

/dev/sda2 on /boot/efi type vfat (rw,relatime,fmask=0077,dmask=0077,codepage=437,iocharset=iso8859-1,shortname=mixed,errors=remount-ro)

tmpfs on /run/user/0 type tmpfs (rw,nosuid,nodev,relatime,size=3272576k,mode=700)

root@srv60805:~# parted -l

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sda: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 2097kB 1049kB bios_grub

2 2097kB 514MB 512MB fat32 boot, esp

3 514MB 8706MB 8193MB linux-swap(v1) swap

4 8706MB 9731MB 1024MB ext4

5 9731MB 10.0TB 9991GB ext4

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sdb: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 10.0TB 10.0TB Linux RAID raid

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sdc: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 10.0TB 10.0TB Linux RAID raid

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sdd: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 10.0TB 10.0TB Linux RAID raid

Error: The primary GPT table is corrupt, but the backup appears OK, so that will

be used.

OK/Cancel? ok

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sde: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 10.0TB 10.0TB Linux RAID raid

Error: The primary GPT table is corrupt, but the backup appears OK, so

that will be used.

OK/Cancel? ok

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sdf: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 10.0TB 10.0TB Linux RAID raid

Error: The primary GPT table is corrupt, but the backup appears OK, so

that will be used.

OK/Cancel? ok

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sdk: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 10.0TB 10.0TB Linux RAID raid

Error: The primary GPT table is corrupt, but the backup appears OK, so

that will be used.

OK/Cancel? ok

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sdi: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 10.0TB 10.0TB Linux RAID raid

Error: The primary GPT table is corrupt, but the backup appears OK, so

that will be used.

OK/Cancel? ok

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sdg: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 10.0TB 10.0TB Linux RAID raid

Error: Both the primary and backup GPT tables are corrupt. Try making

a fresh table, and using Parted's rescue feature to recover

partitions.

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sdl: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: unknown

Disk Flags:

Error: The primary GPT table is corrupt, but the backup appears OK, so

that will be used.

OK/Cancel? ok

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sdj: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 10.0TB 10.0TB Linux RAID raid

Error: The primary GPT table is corrupt, but the backup appears OK, so

that will be used.

OK/Cancel? ok

Model: ATA ST10000NM001G-2M (scsi)

Disk /dev/sdh: 10.0TB

Sector size (logical/physical): 512B/4096B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 10.0TB 10.0TB Linux RAID raid

Peux-tu nous paster le retour d’un :

mdadm --examine --scan

Je viens de voir que sur un précédent fil de support @PascalHambourg t’avais même proposé LVM pour plus de souplesse et de facilité de mise en place … tu préfère utiliser du mdadm en raid0 ?

root@srv60805:~# mdadm --examine --scan

ARRAY /dev/md/0 metadata=1.2 UUID=1f6b5d41:eacdf783:726438b8:415a5815 name=srv60805:0

De ce que je peux voir ton raid est désactivé, il manque pas mal de disque dans le retour de mdadm --detail /dev/md0 qui pourtant possède des flags raid vue par parted -l.

Des disques semblent avoir une table de partition mal vue par parted (en gros l’ensemble des disques vue dans le mdadm --detail /dev/md0).

et effectivement le point de montage /raid doit se sentir bien vide.

Mise à part un redémarrage quels ont été tes dernières opérations ? un redémarrage ne provoque pas tous ça …

J’ai juste fait un redémarrage

Tu as forcément fais des opérations entre ta réinstallation, le montage du volume raid qui n’a surement pas été fait via l’installeur de Debian et l’installation des éventuels applications que tu as ajouté post installation (sans oublier d’éventuels mise à jour ou autres) …

Le tout est de savoir comment as-tu monter ton raid et qu’as tu fais sur les disques/partitions entre temps.

PS : je vois aussi avec le lsblk que les disque sde à sdl sont noté comme amovible … ils sont brancher comment car une carte mère avec 12 ports sata sa cours pas les rue …